Ein Pixel auf einem EVS-Sensor funktioniert ähnlich wie das menschliche Auge Licht wahrnimmt. Rezeptoren in der Netzhaut wandeln Licht in ein elektrisches Signal um, das im Gehirn verarbeitet wird. Die neuronalen Zellen erkennen Licht und Schatten und senden diese Informationen, falls sie eine Veränderung in der Szene erkennen, an den visuellen Kortex (Teil der Großhirnrinde).

In ähnlicher Weise wird das im EVS empfangene Licht in der Lichtempfangseinheit (dem Pixel) erfasst. Dieses Hellligkeitssignal durchläuft zunächst eine Verstärkerschaltung und anschließend einen Komparator, wo es mit einem vorherigen Wert verglichen wird. Wenn das Signal ansteigt oder abfällt, kann ein Ereignis festgestellt werden. Die daraus resultierenden Ereignisse können schließlich an anderer Stelle in der Kamera oder im Bildverarbeitungssystem weiterverarbeitet werden.

Anstelle einer Matrix von Pixelwerten, wie bei den konventionellen Bildsensoren, wird ein Datenstrom von Ereigniswerten gesendet, der die Pixelkoordinaten (X,Y), den Zeitpunkt des Ereignisses und die Lichtpolarität (dunkel zu hell oder hell zu dunkel) für jedes Pixel, das eine Veränderung erkannt hat. Nachdem ein Pixel ein Ereignis ausgelöst hat, wird es auf den neuen Helligkeitswert referenziert. Auf diese Weise entsteht ein Ereignisdatenstrom, der im Gegensatz zu konventionellen bildbasierten Kameras Bildraten von über 10k fps ermöglicht. (Referenz: Erläuterung der EVS-Technologie von Sony: https://www.sony-semicon.co.jp/e/products/IS/industry/technology/evs.html)

Starten Sie die Evaluierung des bahnbrechenden ereignisbasierten Bildsensors, der von Sony Semiconductor Solutions veröffentlicht und in Zusammenarbeit zwischen Sony und PROPHESEE realisiert wurde.

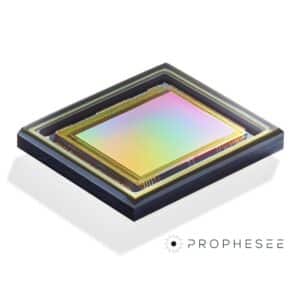

Für die neueste EVS-Generation hat Sony Semiconductor Solutions, ein weltweit führender Anbieter von CMOS-Sensortechnologie und -herstellung, sich mit Prophesee zusammengetan, um zwei neue Sensoren zu produzieren.

Die 1MP IMX636- und VGA IMX637-Sensoren bieten die für einen Event-basierten Vision-Sensor branchenweit kleinste Pixelgröße von 4,86 µm. Sie verfügen über einen integrierten H/W-Ereignisfilter, um unnötige Ereignisdaten zu entfernen, wie z. B. periodische Ereignisse aufgrund von Lichtflimmern oder andere Ereignisse, zum Beispiel bei Objekten, bei denen eine Bewegung unwahrscheinlich ist.

Diese beiden Sensoren wurden durch eine Zusammenarbeit zwischen Sony und Prophesee ermöglicht, indem die CMOS-Bildsensortechnologie von Sony mit der einzigartigen ereignisbasierten Metavision®-Sensortechnologie von Prophesee kombiniert wurde.

Ermöglicht wurde dies durch die Kombination der technischen Merkmale des CMOS-Bildsensors von Sony, der durch die Verwendung einer Cu-Cu-Verbindung eine geringe Pixelgröße und eine hervorragende Leistung bei schlechten Lichtverhältnissen aufweist, mit der ereignisbasierten Metavision®-Sensortechnologie von Prophesee, die eine schnelle Pixelreaktion, eine hohe zeitliche Auflösung und eine hohe Datenausleseleistung ermöglicht.

Seit Juli 2022 bietet Prophesee SA die neuste Version der 5-fach preisgekrönten Metavision® Intelligence Suite (event-basierte Bildverarbeitungssoftware) kostenlos an, inklusive kommerzieller Lizenz.

Seit Juli 2022 bietet Prophesee SA die neuste Version der 5-fach preisgekrönten Metavision® Intelligence Suite (event-basierte Bildverarbeitungssoftware) kostenlos an, inklusive kommerzieller Lizenz.

Sie enthält ein komplettes Set von Machine Learning Tools, neue wichtige Open-Source-Module, fertige Anwendungen, Code-Beispiele und ermöglicht eine völlig kostenlose Evaluierung, Entwicklung und Freigabe von Produkten mit der enthaltenen kommerziellen Lizenz. Die kostenlosen Module in Metavision Intelligence 3.0 sind über C++ und Python APIs verfügbar und beinhalten ein umfassendes Toolkit für maschinelles Lernen.

Mit diesem fortschrittlichen Toolkit können Ingenieure auf einfache Weise Computer-Vision-Anwendungen auf einem PC für eine Vielzahl von Märkten entwickeln, darunter Industrieautomation, IoT, Überwachung, Mobile, Medizin, Automotive und für noch viele mehr.

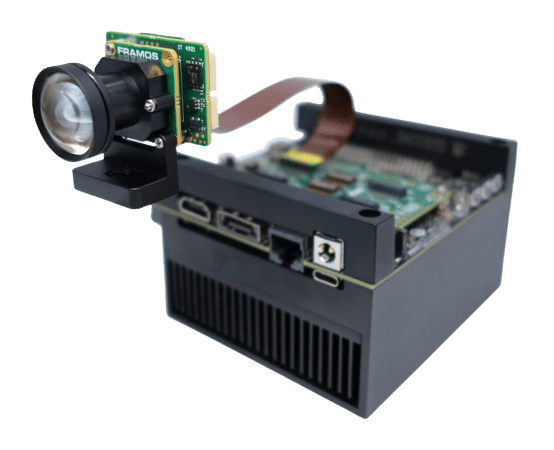

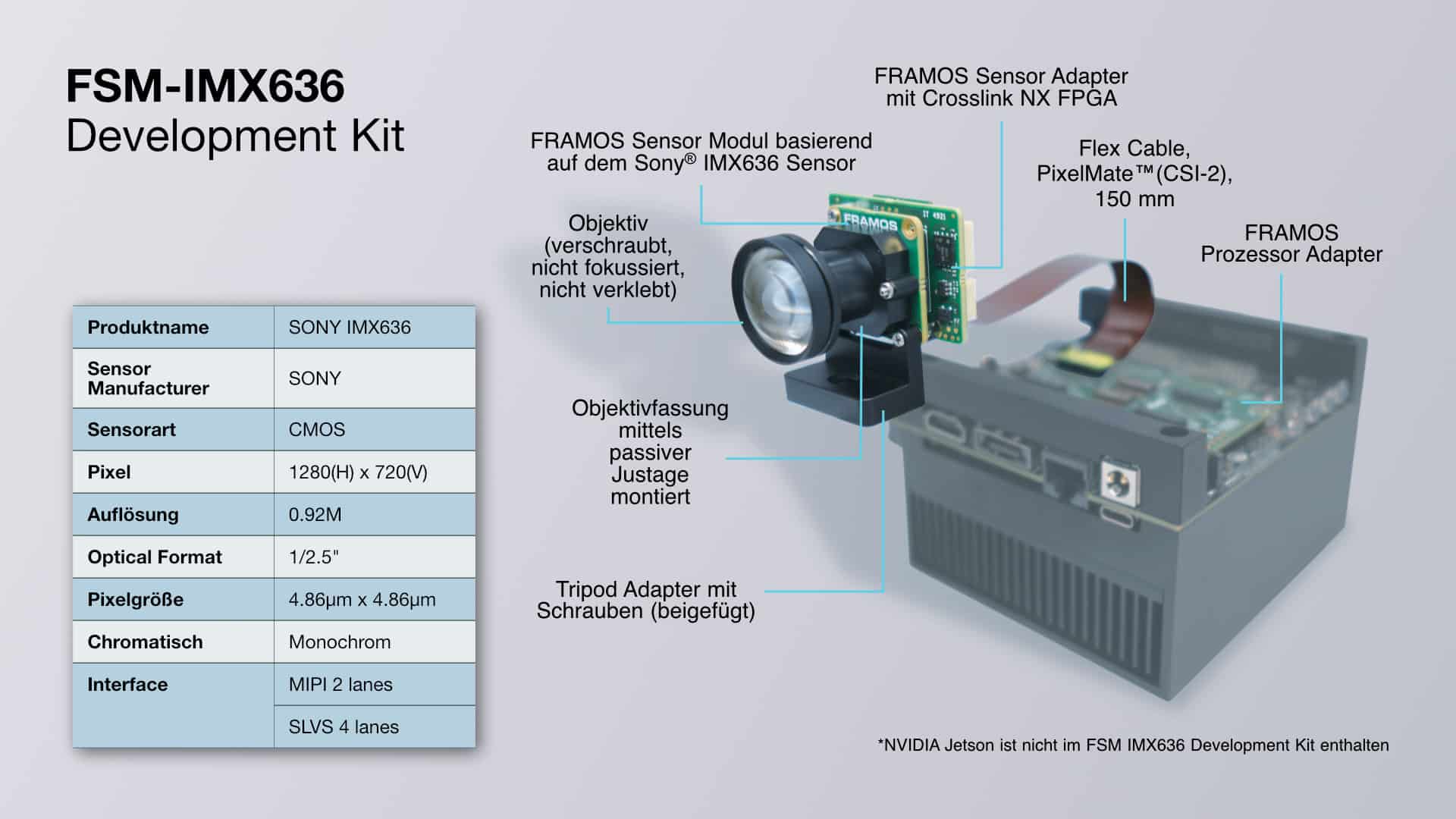

FSM-IMX636 Event-Basierte Bildsensoren Development Kit

Das FSM-IMX636 Devkit, das auf SONY’s und PROPHESEE’s innovativen IMX636 Sensor basiert, erlaubt es Produktentwicklern, Ingenieuren und Innovatoren das Potential der EVS-Technologie in ihren Applikationen auf einfache Art und Weise zu testen.

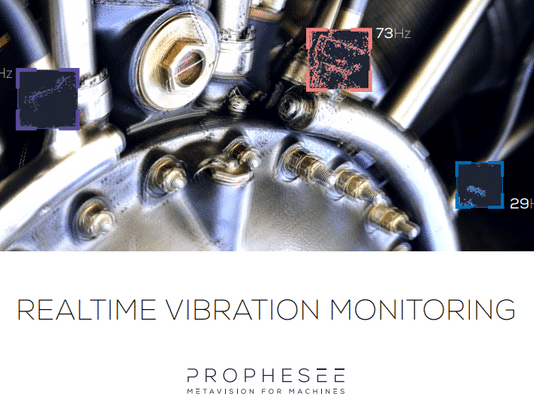

Im Vergleich zum herkömmlichen frame-based Image Sensing, ist mit diesem Kit der Prototypenbau schneller abgewickelt und das Festhalten von sich ultra-schnell bewegenden Objekten oder auch der Frequenzen von Maschinenvibrationen zu einem Bruchteil des Bearbeitungsaufwands der Übertragungsrate und des Energieverbrauchs möglich.

Entdecke EVS-Technologie mit dem FSM-IMX636 Development Kit

Industrielle Automatisierung

Industrielle Prozesse, Inspektion, Überwachung, Objektidentifizierung, Erkennung und Verfolgung, Handhabung, Hochgeschwindigkeits-Bewegungssteuerung (Motion Control) / Robotik und FTS (Fahrerlose Transportsysteme)

IoT & Überwachung

Bewegungserkennung und -analyse, Einbrucherkennung, Erfassung von Verkehrsdaten, Führung von Menschenmengen, Personenzählung, ständige visuelle Erkennung, Gestenerkennung, unbedenklich hinsichtlich der Privatsphäre

Automobilbereich & Mobilität, Drohnen

Autonomes Fahren, Notbremsassistent, Fahrerassistenz, Kollisionsvermeidung, Fußgängerschutz, Insassenerkennung und -klassifizierung, Fahrerüberwachungssysteme, visuelles SLAM (simultane Lokalisierung und Kartierung)

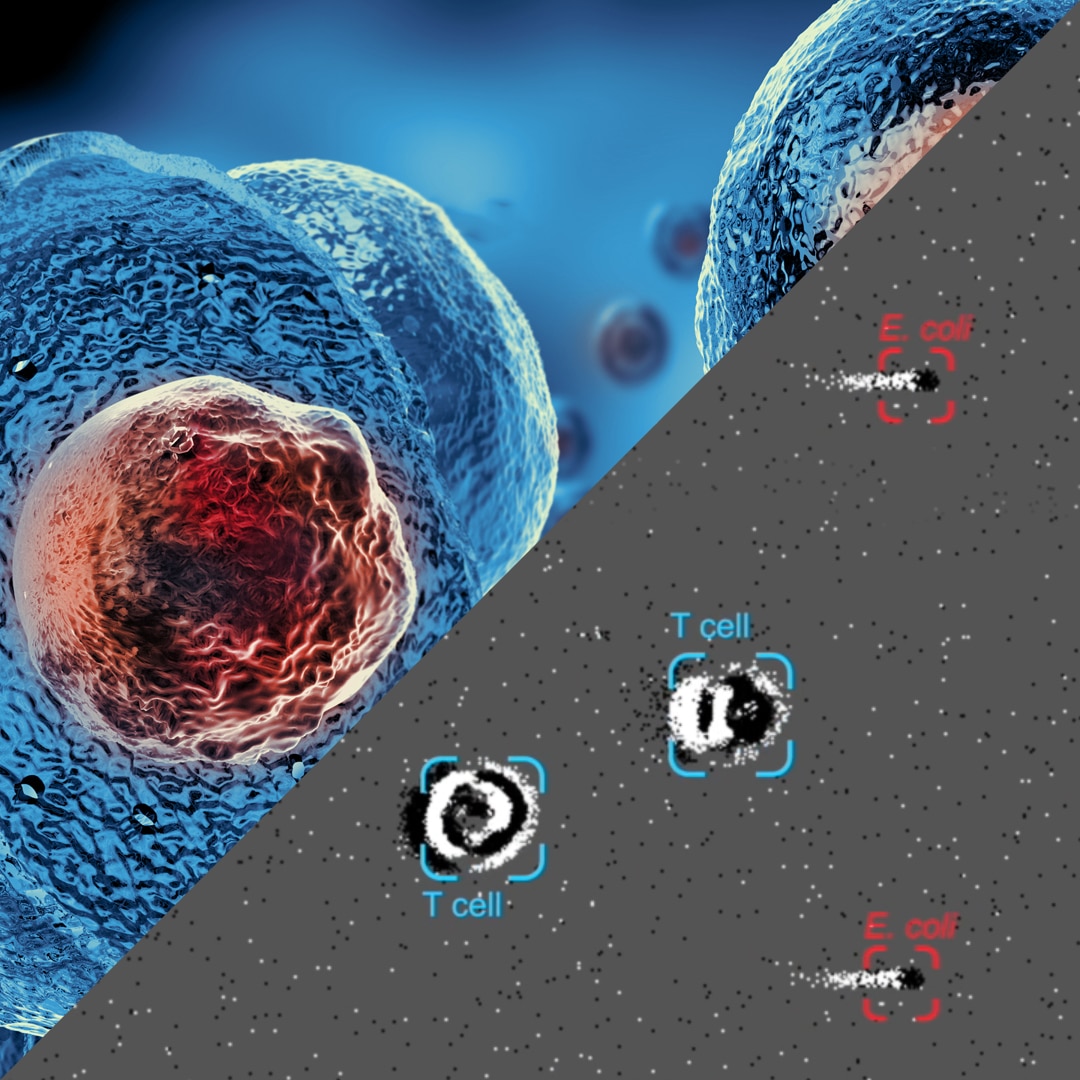

Medizinischer Bereich

Sterilitätstests an lebenden Proben für die Gentherapie, Wiederherstellung des Sehvermögens, Blutproben-Rückverfolgbarkeit