Vom kleinen Sensormodul bis hin zu Künstlicher Intelligenz – Um Drohnen sehen zu lassen, gibt es verschiedene Technologien und Methoden der Bildverarbeitung. Welchen Anforderungen das Vision-System entsprechen muss, hängt von der Art der Anwendung, dem vorhandenen Platz und der benötigten Qualität ab. Dr. Frederik Schönebeck von FRAMOS sprach auf der VDI-Konferenz „Zivile Drohnen im Industrieeinsatz” über die Kriterien für Anwendungen im Mapping, der Objekterkennung und in der Navigation sowie über die Relevanz von Künstlicher Intelligenz für Drohnen.

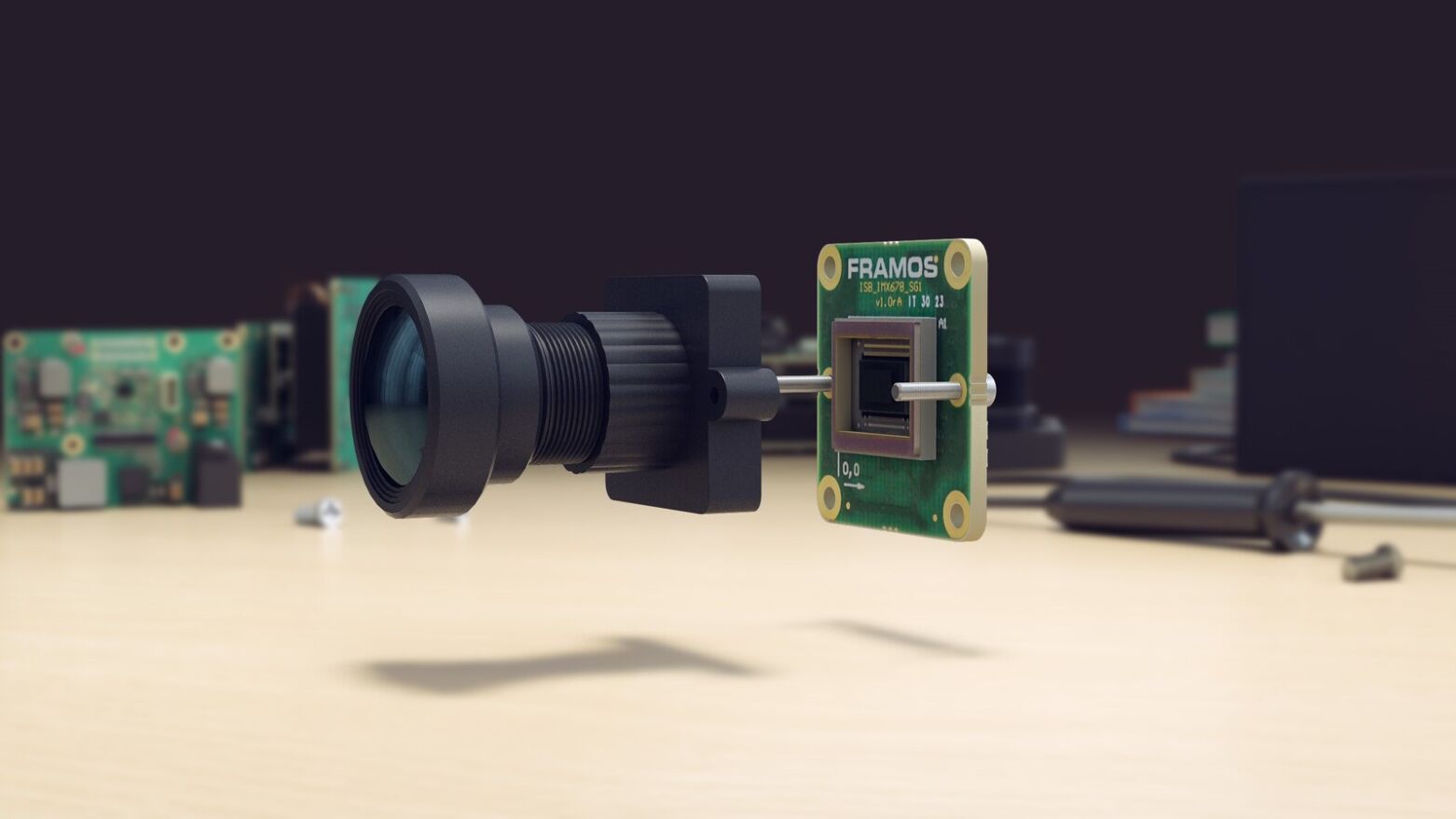

Ein Vision-System bleibt ein Vision-System – es besteht in den allermeisten Fällen zumindest aus einem Bildsensor, einem Prozessormodul, einem Mount und einem Objektiv. Speziell für Drohnen muss das Vision-System jedoch besonders klein und leicht sein. Es darf die Flugleistung so wenig wie möglich beeinflussen. Zusätzlich sind eine hohe Energieeffizienz und geringe Hitzeentwicklung wichtig, da zumeist nur eine eingeschränkte Energieversorgung an Bord besteht und die Reichweite nicht signifikant abnehmen darf. Aus reinen Bild- und Video-Streams leitet eine Drohne keine weiteren Aktionen ab, es handelt sich um sogenannte nicht-funktionale Anwendungen. Funktionale Anwendungen dagegen nutzen die Bilder des Vision-Systems, um darauf basierend zu navigieren, Kollisionen zu vermeiden oder aufgrund des Trackings Folgeaktionen anzustoßen. Funktionale Drohnen werden durch Bildverarbeitung intelligent und zumeist autonom. Die Bildqualität muss in beiden Fällen eine exakte Analyse erlauben und für funktionale Aufgaben müssen die Bilder mit On-Board-Prozessoren in Echtzeit verarbeitet werden können. Die Kombination der Kriterien Größe, Gewicht, Effizienz, Bildqualität und Processing ist auch in Zeiten von Embedded Vision eine große Herausforderung und bedingt eine sorgfältige Auswahl und Zusammenstellung der einzelnen Komponenten.

Drohnen stellen hohe Anforderungen an Embedded Vision und den Bildsensor

Der am besten geeignete Bildsensor für Drohnen und Embedded Vision-Systeme ist ein CMOS-Sensor. Der neue Industriestandard erreicht gegenüber den bisherigen CCD-Pendants aufgrund seiner Architektur eine höhere Geschwindigkeit, eine bessere Bildqualität und ist deutlich kleiner. Entwickler können dabei zwischen Global Shutter- und Rolling Shutter-Verschlussmechanismen wählen. Bei einem Global Shutter (GS) werden alle Pixel gleichzeitig belichtet, die Bewegung im Bild wird quasi eingefroren, es entstehen keine Bewegungsunschärfen oder -verzerrungen. GS-Sensoren sind damit für Aufnahmen in Hochgeschwindigkeitapplikationen geeignet. Das komplexe Pixeldesign hat jedoch größere Pixel und damit größere Sensorabmessungen zur Folge. Außerdem schlagen sie mit einem höheren Stückpreis zu Buche.

Die Pixelreihen bei einem Rolling Shutter (RS) werden nacheinander belichtet, wodurch bei Bewegung Artefakte im Bild entstehen können. Der Aufbau von RS-Sensoren ist weniger komplex, was sich in einer höheren Sensitivität niederschlägt. Dies wiederum erlaubt im Vergleich zu Global-Shuttern kleinere und günstigere Sensoren. Drohnen-Entwickler sollten die Vor- und Nachteile für ihr System gut abwägen.

“Ein größerer Sensor zieht immer auch ein größeres Objektiv und ein größeres Gesamtsystem nach sich. Das wirkt sich auf das Gewicht, den Preis und auch den Stromverbrauch aus, gerade bei Drohnen müssen Nutzen und Aufwand sehr genau tariert werden“, verdeutlicht Dr. Frederik Schönebeck.

Exkurs: Die Bewegungsartefakte eines Rolling Shutters können etwa den SLAM-Algorithmus und damit die Posenschätzung einer Drohne beeinträchtigen. Diese Störeffekte können durch das Zusammenspiel des Bildsensors mit den Daten eines IMU-Sensors minimiert werden. Die Sensor-Fusion mit IMU-Daten hat den weiteren Vorteil, dass die Position der Drohne im dreidimensionalen Raum besser bestimmt werden kann, was zu einem stabileren und sichereren Flugverhalten führt. Mehr dazu lesen Sie in unserem Artikel „Exakte Kombination: Vision- und IMU-Daten sorgen für genaue Posenbestimmung bei Drohnen“.

Anwendungsbeispiel “Mapping”

Beim Mapping werden Drohnen dazu eingesetzt, hochauflösendes Kartenmaterial zu erstellen. Sie überfliegen dazu meist aus hohen Flughöhen das zu kartierende Gebiet. Vision-Systeme für Mapping-Drohnen müssen eine sehr hohe Auflösung bieten, die Bildqualität steht ganz klar im Vordergrund, teilweise auch simultan in mehreren Frequenzbändern.

Besonders geeignet für Mapping-Anwendungen sind großformatige Sensoren, die mit Auflösungen von 50 bis 150 Megapixel und einem >74dB Dynamikumfang eine sehr gute Bildqualität bieten.

Bild 1: Sensor-Formate und die dazugehörigen Bild-Formate

Ein großer Sensor mit einer hohen Auflösung bietet den Vorteil, dass mit einer Aufnahme ein größeres Gebiet aufgenommen werden kann. Dies ermöglicht einen schnelleren Überflug und eine effizientere Vermessung.

Bild 2: Aufnahmegebiet verschiedener Sensor-Auflösungen bei gleicher Bildqualität

Bild 2: Aufnahmegebiet verschiedener Sensor-Auflösungen bei gleicher Bildqualität

Die Drohne kartiert die Erdoberfläche aus großer Höhe, somit ist die Relativgeschwindigkeit, mit der sich die Drohne über die Erde bewegt gering – die dadurch resultierenden Bewegungsartefakte im Bild sind minimal und können bei Bedarf durch einen mechanischen Verschluss vollständig eliminiert werden. Ein wirtschaftlich günstigerer Rolling Shutter-Sensor genügt für Mapping-Drohnen daher in vielen Fällen. Doch die großen Sensoren bedingen große Mounts und große Objektive. Für das Vision-Gesamtsystem muss bei hohen Auflösungen also mehr Platz und Bauraum im Drohnen-Design eingeplant werden. Zudem muss für eine mechanische Bildstabilisierung, für Objektivstabilisatoren, für ein Gimbal oder ähnliche Ausgleichsmethoden Platz in der Architektur hinzugerechnet werden.

Dr. Frederik Schönebeck erklärt: „Im Grunde sind Mapping-Anwendungen in Drohnen hochpreisige Vermessungssysteme auf Basis präziser Bildverarbeitung.“

Um Zeit zu sparen und für die Kartierung am Boden eine gute Basis zu bieten, werden die aufgenommenen Bilder vorzugsweise über FPGA-Prozessoren an Bord der Drohne vorverarbeitet. Die Entwickler müssen für diese Masse an Daten eine starke Prozessorarchitektur und genügend Speicherkapazität zur Verfügung stellen. Das finale Processing findet dann nach dem Drohnenflug offline statt. Dementsprechend benötigt das Vision-System keine mobile Datenübertragung. Mapping-Drohnen koppeln häufig Lidar-Systeme an die Bildverarbeitung, um eine höhere Genauigkeit und zusätzliche Messdaten zu generieren. Diese Kombinationen und Schnittstellen sorgen für eine höhere Komplexität der Designs und Architekturen, welche in der Zeit- und Ressourcenplanung berücksichtigt werden müssen.

Anwendungsbeispiel “Videostreaming”

Drohnen sind die neue Normalität in der Überwachung und Sicherheit. Sie ermöglichen die Beobachtung und Inspektion von schwer zugänglichem Gelände, weitläufigen Gebieten und sind unauffällig und beweglich. Videostreaming ist damit eine der häufigsten Anwendungen für Drohnen. Die unbemannten Flugobjekte müssen klein sein und im wahrsten Sinne des Wortes über Augen verfügen.

Wichtige Faktoren für die Drohnen-Entwicklung mit Videostreaming in der Überwachung sind die Größe, das Gewicht und die Kosten. Üblicherweise werden Sensoren mit Auflösungen zwischen 1 und 10 Megapixel gewählt, die maximal ein 4/3 Zoll-Format oder kleiner aufweisen. Zusätzlich zum Sensor, Mount (M12 bis 4/3 Zoll) und Objektiv ist in den Überwachungsdrohnen meist eine applikations-spezifische ISP verbaut. Die Drohne wertet die Überwachungsbilder damit in Echtzeit aus und kann in funktionalen Systemen Folgeaktionen anstoßen.

„Für eine hohe Qualität der Bildanalyse und -auswertung, gerade unter schwachen Lichtbedingungen oder im 24h-Betrieb, benötigen Echtzeit-Applikationen im Sicherheits- und Überwachungssektor Sensoren mit großem Dynamikumfang und hohen Bildraten.“

Zusätzlich sind in Überwachungsdrohnen große Pixel mit hoher Aufnahmekapazität, HDR-Modi und niedrige Signal-Noise-Ratio Kriterien für die Auswahl des passenden Sensors vorhanden. Auch der Dynamikumfang lässt sich für kontrastreichere und schärfere Bilder steigern, ohne dafür Bewegungsartefakte in Kauf nehmen zu müssen. Spezielle Überwachungssensoren wie etwa Sony’s IMX294 mit Quad-Bayer-Struktur geben im Normalmodus 2×2 gebinnte Pixel aus, vier Pixel werden also für eine höhere Dynamik zu einem „Super-Pixel“ zusammengefasst. Im HDR-Modus wird aus zwei Pixeln dieses Quad-Arrays zunächst eine kurze und den anderen beiden Pixeln eine lange Belichtungszeit zugewiesen (Bild3). Dadurch wird die zeitliche Trennung der kurzen und langen Belichtungszeit komplett eliminiert, was HDR-Bilder von bewegten Objekten mit minimalen Artefakten ermöglicht (Bild 4).

Bild 3: Quad-Bayer-Pixelstruktur im Normal- und HDR-Modus

Bild 4: Geringe Artefakte im Quad-Bayer HDR-Bild

Bild 4: Geringe Artefakte im Quad-Bayer HDR-Bild

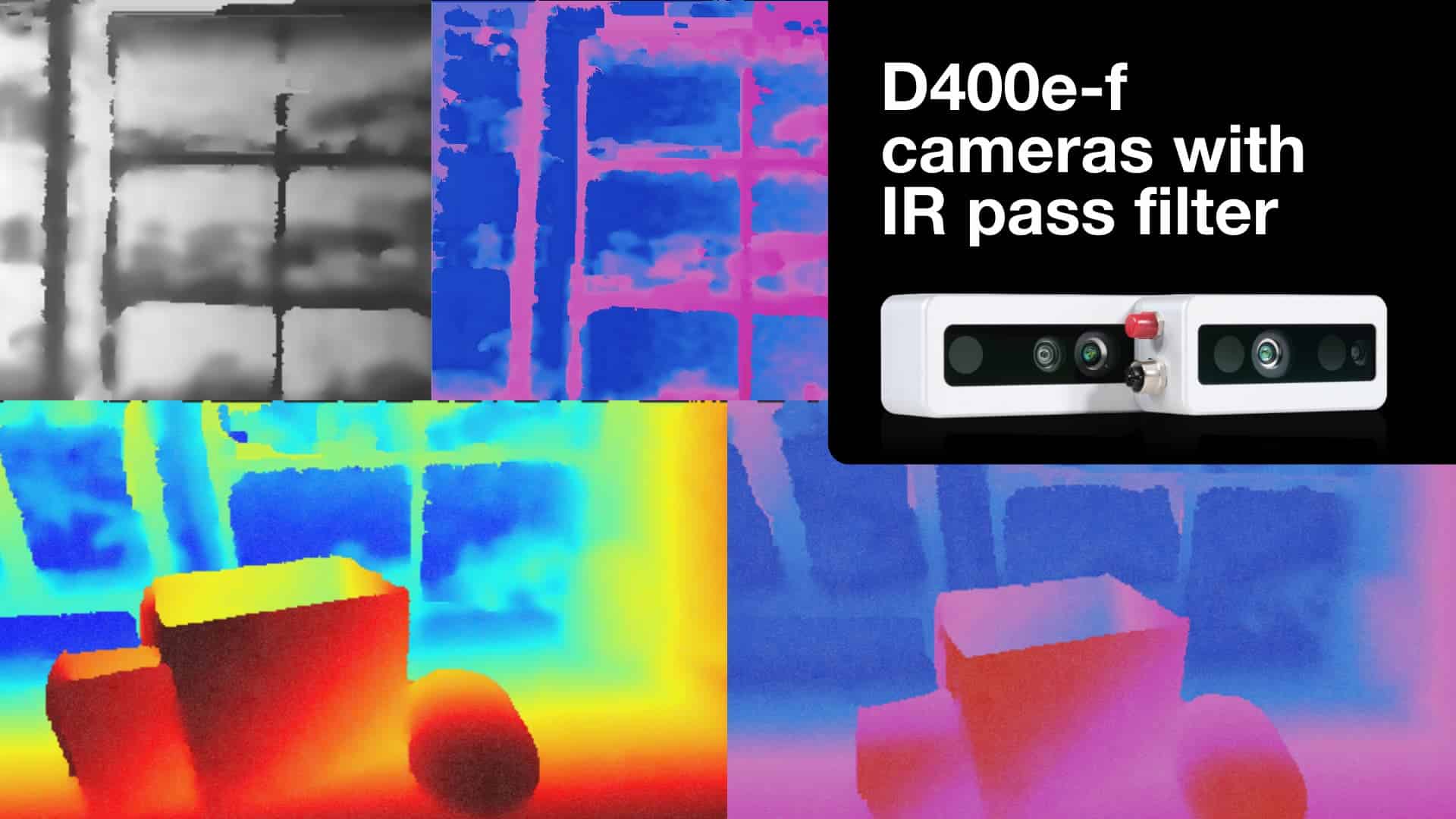

Für die Überwachung bei Nacht können weitere Funktionalitäten wie beispielsweise eine in das Vision-System integrierte Infrarot-Beleuchtung die Bildaufnahme und -erkennung verbessern. Treten in der Applikation vermehrt Richtungswechsel bzw. Beschleunigungskräfte auf, müssen zusätzlich Optionen zur mechanischen, optischen oder elektronischen Bildstabilisierung in Betracht gezogen werden. Ist das Eliminieren von Bewegungsartefakten eines der Hauptkriterien in einer Applikation, sollte direkt ein Sensor mit Global-Shutter-Verschluss gewählt werden. Für das Video-Encoding rät Schönebeck bei Drohnen zum H.264/H.265 Encoding. Durch das Encoding werden die Bilddaten bei minimalem Qualitätsverlust komprimiert. Dadurch wird weniger Speicherplatz auf dem Speichermedium beziehungsweise eine geringere Bandbreite bei Echtzeitübertragung via Wifi oder 3G/4G/5G benötigt.

Anwendungsbeispiel „Tracking / Identifikation”

Funktionale Drohnen nutzen vision-basiertes Tracking, um sich selbst und ihre Umgebung im Raum zu erkennen und auf dieser Basis zu navigieren. Das Tracking ermöglicht es beispielweise FollowMe-Drohnen einem Menschen zu folgen oder Hindernisse zu umfliegen. Konkret nutzen Drohnen dazu die 2D- oder 3D-Bilddaten eines Vision-Systems, um ihre Umgebung und die sich darin befindenden Objekte zu identifizieren. Die Drohne kann sich auf Grundlage dieser Daten selbst steuern, ihre Flugrichtung und Geschwindigkeit anpassen, landen, ausweichen und Objekte verfolgen. Die Vision-Daten werden für eine exaktere Posenschätzung über alle sechs Freiheitsgrade im dreidimensionalen Raum teilweise mit Daten anderen Sensoren, wie etwa IMU’s (inertial measurement unit), fusioniert. Bei Tracking-Anwendungen ist die Bildqualität weniger wichtig, da das Bild direkt vom Prozessor ausgewertet wird und die Kamera effektiv als Sensor arbeitet.

Das Kamerasystem einer Drohne, welche auf Tracking setzt, ist zumeist sehr tief in die Drohnensteuerung eingebettet und eher klein. Sensoren im 1/3-Zoll-Format mit einer Auflösung bis 2 Megapixel und M12-Objektive stellen das Maximum dar und werden an komplexe SoC-Rechenarchitekturen angeschlossen. Die heterogenen Systeme aus CPU, FPGA und ISP weisen viele Schnittstellen zu weiteren Systemen an Bord der Drohne auf. Diese Komplexität muss beim Kalkulieren der Entwicklungs- und Integrationszeit berücksichtigt werden.

„Um Bewegungsartefakte zu minimieren und die Präzision der Tracking-Daten zu maximieren, ist der Einsatz von Global Shutter-Sensoren empfehlenswert“, sagt Dr. Frederik Schönebeck. Für eine schnelle und einfache Generierung von 3D-Daten kommen dabei Stereo Vision-Kameras oder -Systeme sowie Time of Flight-Sensoren in Frage. Die so generierten Daten werden über das SoC automatisch ausgewertet – so werden anschließend eigenständig konkrete Folgeentscheidungen getroffen. Da für Tracking-Drohnen nicht die Qualität des Kamerabildes im Fokus steht, stellen sie meist extreme Anforderungen an eine geringe Größe, leichtes Gewicht und niedrige Kosten.

Wie Künstliche Intelligenz der Objekterkennung dient

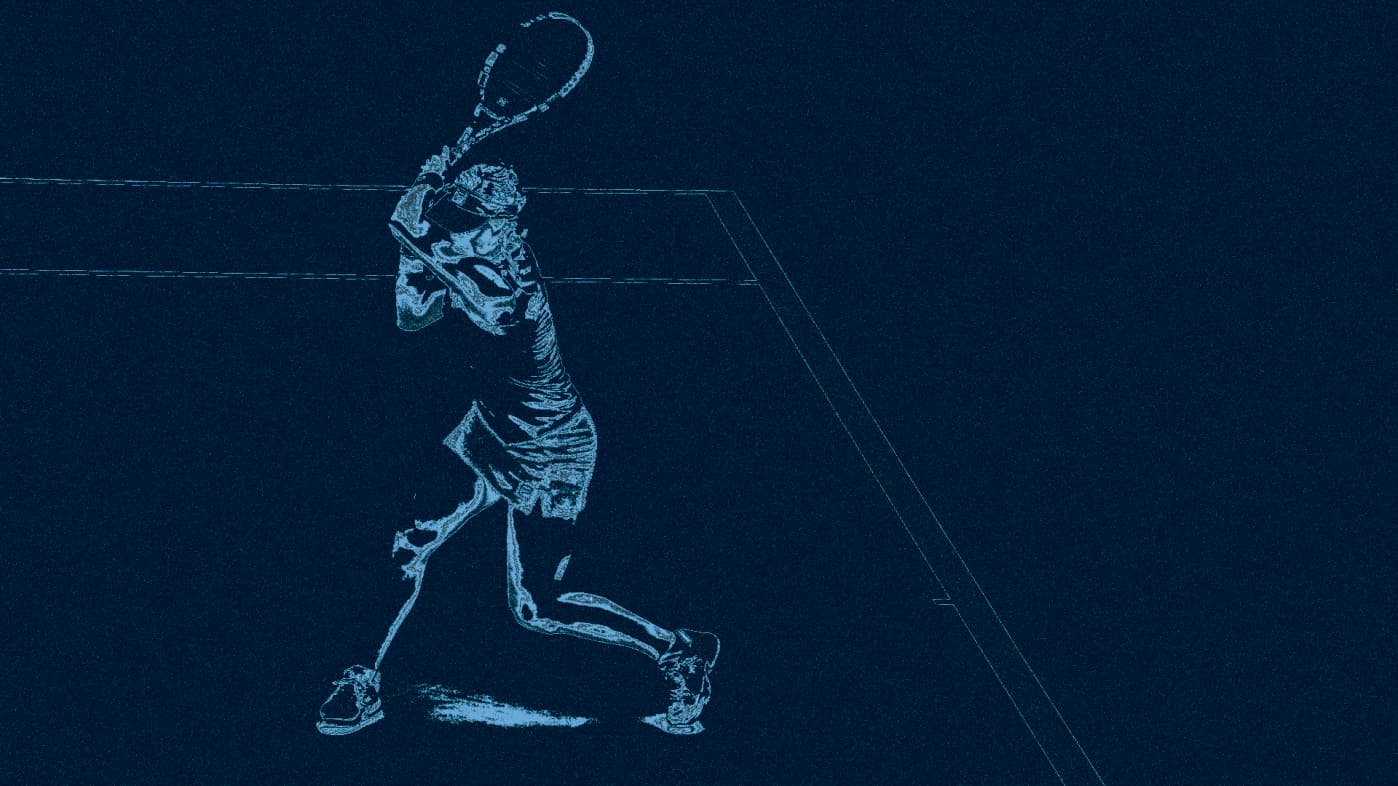

Deep Learning-Algorithmen oder Künstliche Intelligenzen bieten für Drohnen mehr Sicherheit durch präzisere Kollisionsvermeidung und ermöglichen das autonome Tracking von Objekten und Personen. Für die Kollisionsvermeidung muss die Drohne selbstständig und in Echtzeit Hindernisse wie Wände, Bäume oder andere Objekte erkennen und präzise Ausweichmanöver durchführen. Beim Tracking erkennt die Drohne selbständig das zu verfolgende Objekt und fliegt diesem automatisch hinterher.

![]() Bild 5: Künstliche Intelligenz hilft Drohnen, Objekte und Menschen besser zu identifizieren

Bild 5: Künstliche Intelligenz hilft Drohnen, Objekte und Menschen besser zu identifizieren

Für diese Aufgaben trainieren neuronale Netze die Software auf die Erkennung von Objekten. Mindestens 10.000 Bilder, besser mehrere Millionen, sind als verlässliche Testdaten für das maschinelle Lernen auf einem Hochleistungsrechner, etwa einer GPU, notwendig. Die Objekterkennung im Normalbetrieb erfordert dann lediglich eine kleine, energieeffiziente Prozessorarchitektur, wie beispielsweise einen ASIC-Chip.

KI unterstützt Stereo Matching

Neuronale Netze helfen nicht nur bei der Objekterkennung, sondern bereits beim eigentlichen Erstellen der Tiefeninformation in einer 3D-Kamera und führen zu präziseren Ergebnissen.

Stereo Vision-Verfahren nutzen die Distanzbestimmung mittels Triangulation zwischen zwei Kameras zur Erstellung der 3D-Daten. Über das Stereo Matching zweier jeweils zueinander gehörender Referenzpunkte im linken und im rechten Bild wird die Disparität berechnet. Die daraus resultierenden „Dense Disparity Maps“ enthalten die dritte Dimension als Farbcodierung. Je kleiner die Disparität und je dunkler der jeweilige Punkt dargestellt wird, desto weiter weg befindet er sich von der Kamera.

Das Training über neuronale Netze nutzt ein Bild, beispielsweise das linke, als Vergleichsdatensatz. Das rechte Bild fungiert als „Ground Truth“. Für das Stereo Matching werden diese Trainingsdaten hinsichtlich Distanz, Perspektive und Szenerie auf die spezielle Anwendung optimiert. Dadurch werden die Kanten von Objekten robuster detektiert und sogenannte „Flying Pixel“, also Ausreißer in der Tiefenkarte, minimiert. Außerdem entsteht eine „Confidence Map“, welche hilft, die Qualität der erstellten Tiefeninformation einzuschätzen und dadurch robustere Entscheidungen zu treffen.

Bild 6: Neuronale Netze helfen im Stereo Matching für eine exakte Erkennung von Kanten

Bild 6: Neuronale Netze helfen im Stereo Matching für eine exakte Erkennung von Kanten

Was Drohnen-Entwickler wissen sollten

Grundsätzlich lässt sich sagen: Jede Drohnenanwendung ist unterschiedlich und erfordert ein individuell und spezifisch optimiertes Kamerasystem. Dabei gilt es den besten Kompromiss aus Bildqualität, Leistungsaufnahme, Rechenleistung sowie Größe und Gewicht zu finden. Insbesondere die gewünschte Bildqualität sowie Bewegung beeinflusst mit der Wahl des optimalen Sensors die Größe des Gesamtsystems. Dies gilt insbesondere für Drohnen, welche auf Embedded Vision setzen und deren Kameras tief in Drohnenelektronik integriert sind. Schnittstellen zu weiteren Drohnen-Systemen erhöhen die Komplexität der Architektur. Für eine Steuerung der Drohne über Bilddaten in Echtzeit wird zusätzlich eine leistungsfähige On-Board-Verarbeitung gebraucht. Künstliche Intelligenzen wie neuronale Netze können die Kamera als „Sensor“ erheblich unterstützen und dadurch die Präzision der autonomen Drohnensteuerung und Objekterkennung verbessern.

Bild 1, 2, 3 und 4: (c) Sony Semiconductor Solutions – Bild 5: (c) Smolyanskiy et al. 2017 https://arxiv.org/abs/1705.02550

Vom kleinen Sensormodul bis hin zu Künstlicher Intelligenz – Um Drohnen sehen zu lassen, gibt es verschiedene Technologien und Methoden der Bildverarbeitung. Welchen Anforderungen das Vision-System entsprechen muss, hängt von der Art der Anwendung, dem vorhandenen Platz und der benötigten Qualität ab. Dr. Frederik Schönebeck von FRAMOS sprach auf der VDI-Konferenz „Zivile Drohnen im Industrieeinsatz” über die Kriterien für Anwendungen im Mapping, der Objekterkennung und in der Navigation sowie über die Relevanz von Künstlicher Intelligenz für Drohnen.

Vom kleinen Sensormodul bis hin zu Künstlicher Intelligenz – Um Drohnen sehen zu lassen, gibt es verschiedene Technologien und Methoden der Bildverarbeitung. Welchen Anforderungen das Vision-System entsprechen muss, hängt von der Art der Anwendung, dem vorhandenen Platz und der benötigten Qualität ab. Dr. Frederik Schönebeck von FRAMOS sprach auf der VDI-Konferenz „Zivile Drohnen im Industrieeinsatz” über die Kriterien für Anwendungen im Mapping, der Objekterkennung und in der Navigation sowie über die Relevanz von Künstlicher Intelligenz für Drohnen.