Die Evolution hat den Menschen mit zwei Augen ausgestattet. Aus gutem Grund: nur so können wir räumlich sehen und damit nicht nur Formen und Umrisse erkennen, sondern auch Entfernungen einschätzen. Was für uns ganz natürlich ist, ist in der industriellen Bildverarbeitung eine komplexe Aufgabe: Wie entstehen 3D-Bilder genau und welche Technologien helfen bei der Umsetzung, um Maschinen das Sehen und Denken beizubringen?

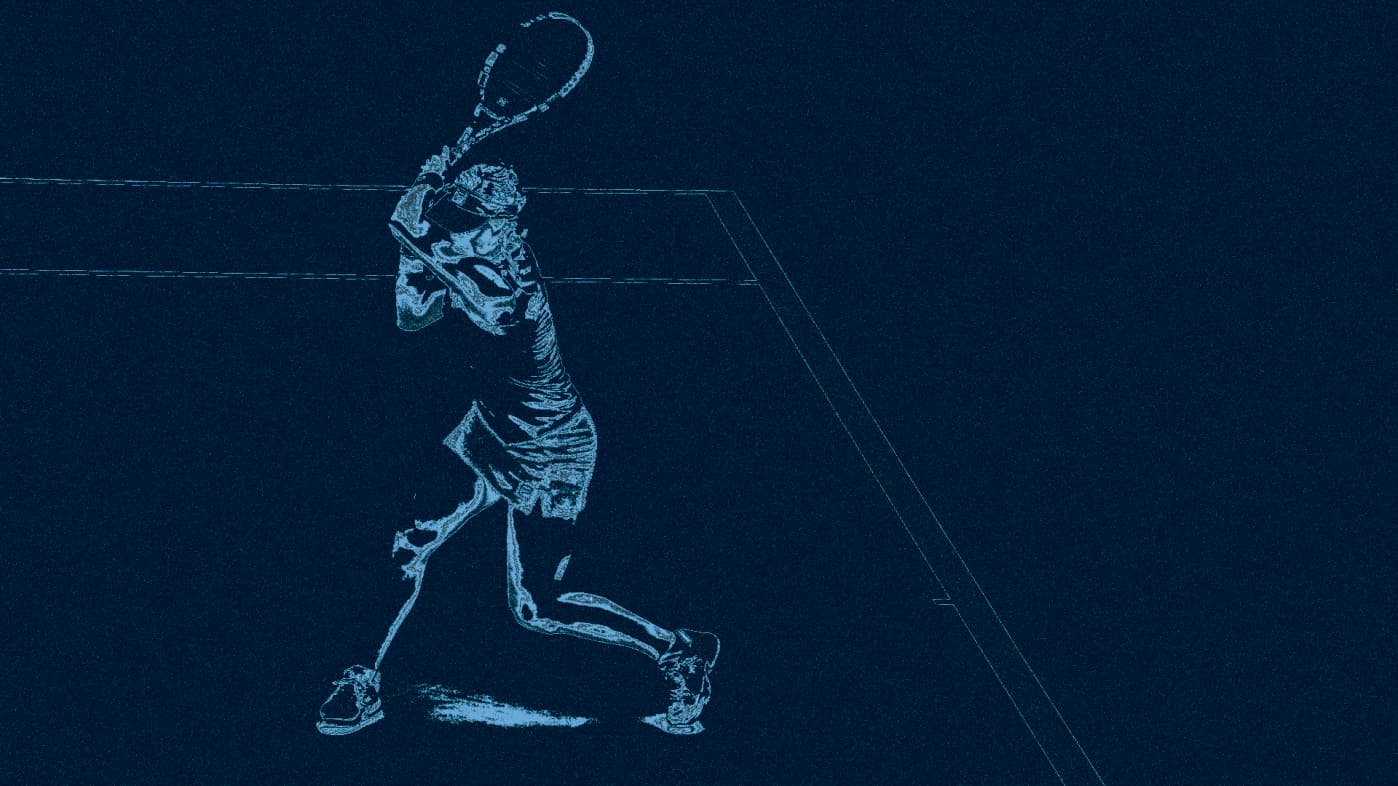

Babys haben noch kein Gefühl dafür, wie weit ihre Augen auseinanderstehen und können ohne diese Erfahrung nicht räumlich sehen. Sie können noch nicht unterscheiden, ob etwas weit weg oder sehr klein ist, sie sehen nur zweidimensional. Erwachsene Menschen verfügen über räumliches Sehen, was bedeutet, dass sie einschätzen können, wie weit ein Objekt entfernt ist. Diese inhärente Triangulation basiert auf Erfahrung. Nur die Erfahrung sagt, dass der Mensch am hinteren Rand des Spielfeldes in Abbildung 1 eben keine auf der Hand des Mädchens stehende Playmobil-Figur ist. Klassische 2D-Vision-Programme wissen dies nicht und müssen mit Schätzungen und Näherungswerten arbeiten, welche sie mithilfe komplizierter Algorithmen erlernen, um die ungefähren 3D-Koordinaten und Distanzen eines Objektes zu bestimmen. Verfahren dieser Art sind nicht nur aufwändig, sondern auch ungenau und auf einen bestimmten Abstand limitiert. In der modernen Automatisierung und Mensch-Maschine-Kollaboration sind präzise 3D-Daten unverzichtbar für eine exakte Messung und Interaktion in Echtzeit. Die verschiedenen 3D-Verfahren sind mittlerweile ausgereift und oft als fertig einsetzbare Kameras und Module am Markt verfügbar. Der Artikel beleuchtet drei der häufigsten technologischen Vorgehensweisen mit ihren Vorteilen und Nachteilen für die Generierung exakter 3D-Daten.

Babys haben noch kein Gefühl dafür, wie weit ihre Augen auseinanderstehen und können ohne diese Erfahrung nicht räumlich sehen. Sie können noch nicht unterscheiden, ob etwas weit weg oder sehr klein ist, sie sehen nur zweidimensional. Erwachsene Menschen verfügen über räumliches Sehen, was bedeutet, dass sie einschätzen können, wie weit ein Objekt entfernt ist. Diese inhärente Triangulation basiert auf Erfahrung. Nur die Erfahrung sagt, dass der Mensch am hinteren Rand des Spielfeldes in Abbildung 1 eben keine auf der Hand des Mädchens stehende Playmobil-Figur ist. Klassische 2D-Vision-Programme wissen dies nicht und müssen mit Schätzungen und Näherungswerten arbeiten, welche sie mithilfe komplizierter Algorithmen erlernen, um die ungefähren 3D-Koordinaten und Distanzen eines Objektes zu bestimmen. Verfahren dieser Art sind nicht nur aufwändig, sondern auch ungenau und auf einen bestimmten Abstand limitiert. In der modernen Automatisierung und Mensch-Maschine-Kollaboration sind präzise 3D-Daten unverzichtbar für eine exakte Messung und Interaktion in Echtzeit. Die verschiedenen 3D-Verfahren sind mittlerweile ausgereift und oft als fertig einsetzbare Kameras und Module am Markt verfügbar. Der Artikel beleuchtet drei der häufigsten technologischen Vorgehensweisen mit ihren Vorteilen und Nachteilen für die Generierung exakter 3D-Daten.

Abbildung 1: Optische Täuschung bei 2D-Aufnahmen

Passive Stereo Vision: 2-mal 2D gleich 3D

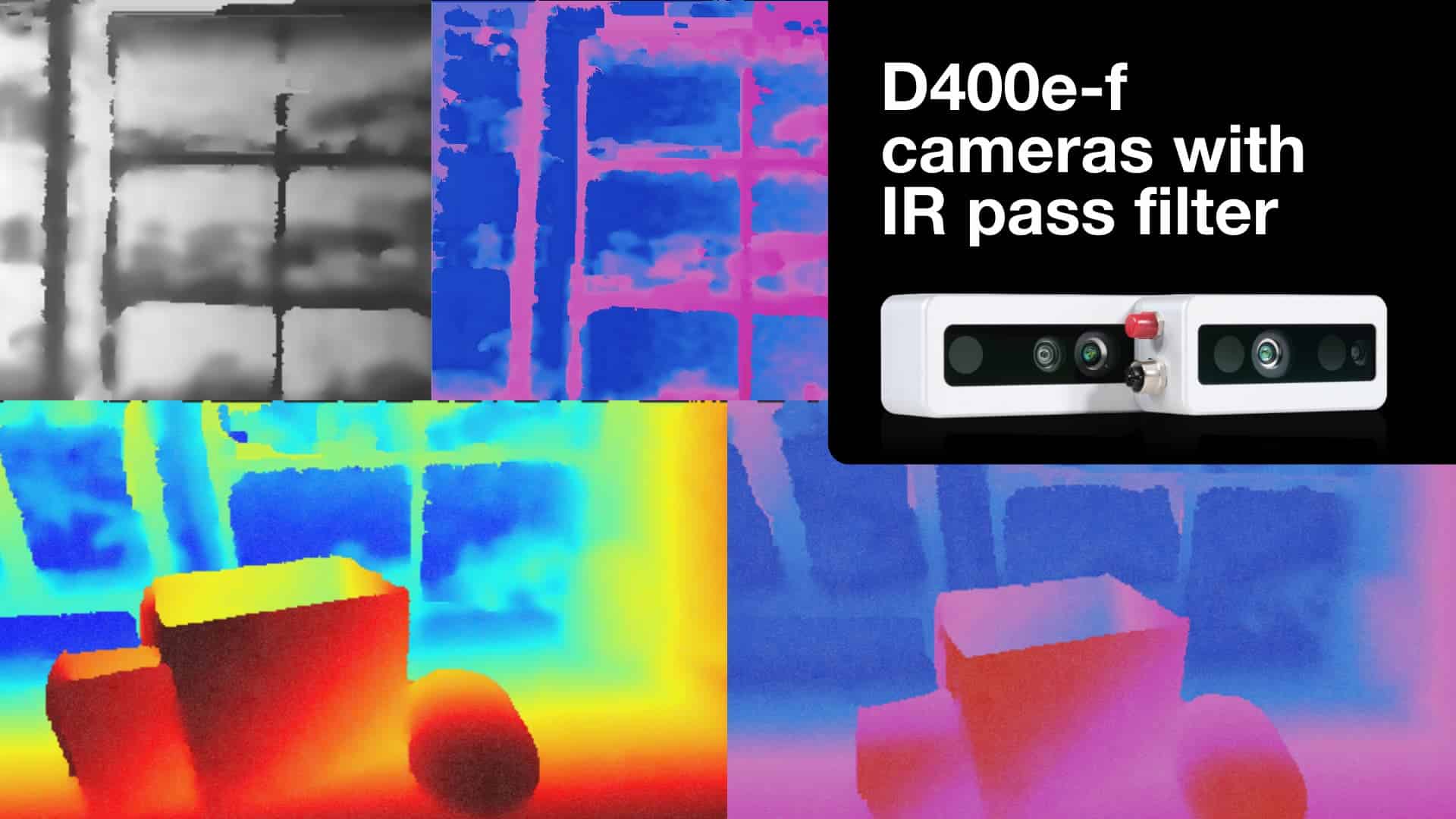

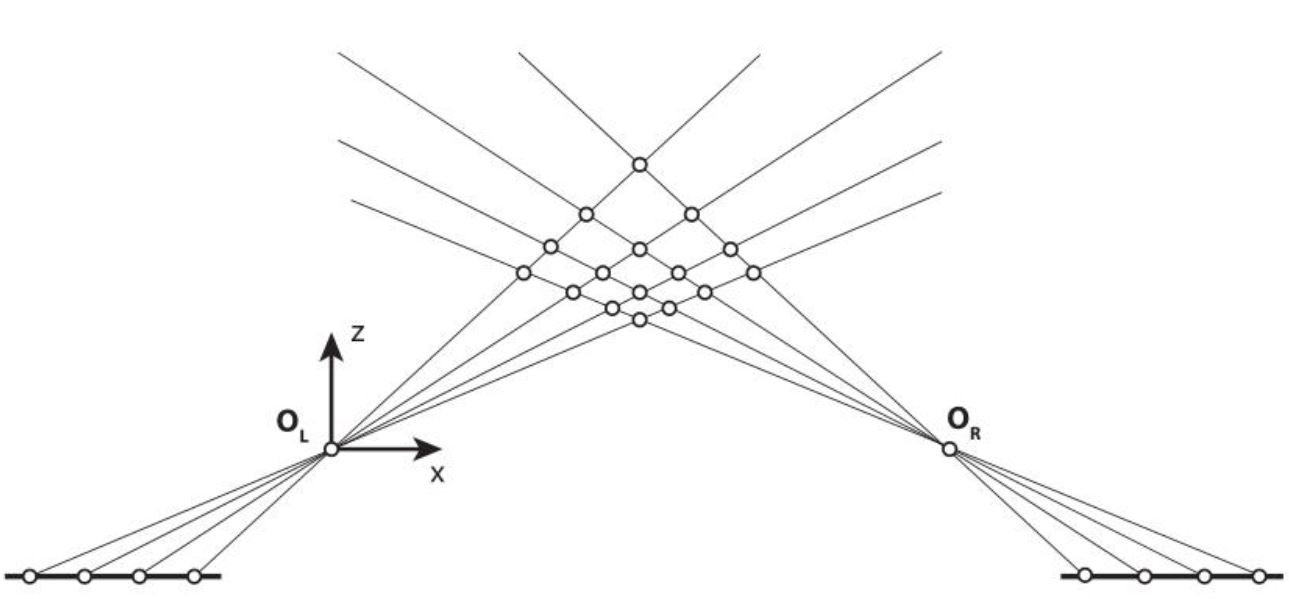

Bei modernen Stereo Vision-Verfahren sind zumeist zwei Kameras in einem fixierten Abstand zueinander installiert. Die Distanzbestimmung erfolgt durch Triangulation der jeweils zueinander gehörenden Referenzpunkte im linken und im rechten Bild, durch Berechnung der Disparität. Die daraus resultierenden „Dense Disparity Maps“ enthalten die dritte Dimension mit einer Farbcodierung. Je kleiner die Disparität und je dunkler der jeweilige Punkt dargestellt wird, desto weiter weg befindet er sich von der Kamera.

Abbildung 2: In Disparitäts-Karten werden Distanzen durch Farbcodierungen wiedergegeben.

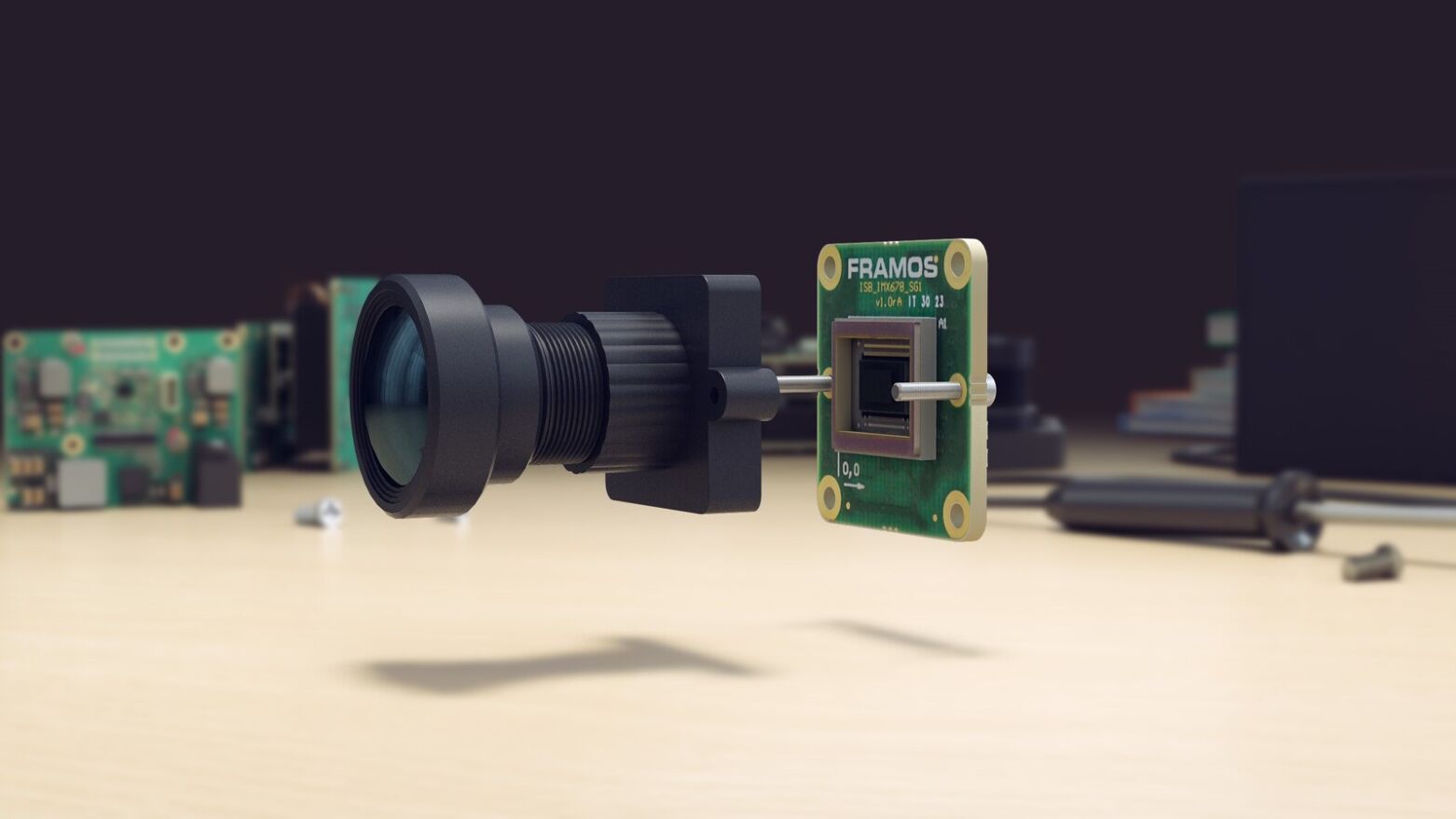

Heutige Stereo Vision-Kameras sind zumeist auf Boardlevel- / Modul-Ebene oder als fertiges Produkt in einem festen Gehäuse erhältlich. Die Kameras sind vorkalibriert, 3D-Bilder und Tiefenkarten entstehen für strukturierte Oberflächen ohne größeren rechnerischen Aufwand. Die Vorteile von disparitätsbasierten Triangulationstechniken liegen darin, dass etwa keine Diskretisierungsstufen für den Abstand bestehen und damit eine sehr hohe Genauigkeit erreicht werden kann. Nachteile ergeben sich nur bei sehr homogenen Texturen, da die gesamte Oberfläche gleich wirkt und die Kamera keine Referenzpunkte detektieren kann. Für diese Einsatzszenarien eignen sich aktive 3D-Techniken.

Aktive Stereo-Vision mit Musterprojektion

Über die Projektion sogenannter Pattern fügen aktive Stereo Vision-Verfahren dem Bild mit Hilfe von strukturiertem Licht zusätzliche Informationen hinzu, um die nicht vorhandenen Texturen zu simulieren. Eine inverse Kamera sendet dazu Strahlen von einem 2D-Array auf die Oberfläche, eine herkömmliche 2D-Kamera sucht nach dem projizierten Objekt, etwa einem roten Punkt. Dazu wird die Triangulation und Winkelmessung innerhalb der entstehenden geometrischen Dreiecke genutzt, da die Entfernung zwischen inverser Kamera und normaler Kamera bekannt, kalibriert und fixiert ist. Dimensionen, Entfernungen und Abstände können berührungslos, präzise und schnell vermessen werden. Der Nachteil dieser aktiven Stereo Vision-Methode liegt in der möglichen Auffächerung der Strahlen bei hoher Distanz. Die „auseinander driftenden“ Punkte können zu einer schlechteren Auflösung und damit zu einem ungenaueren Ergebnis führen. Für extrem schnelle Messungen unter geringen Auflösungen kommen daher auch Time of Flight-Kameras in Frage.

Time of Flight

Das Messprinzip von Time of Flight-Kameras (TOF) ist radarähnlich aufgebaut und beruht auf der Zeit, die ein

und damit wenig Strom. Für komplexere Aufgaben, Embedded Vision-Applikationen und höhere Auflösungen eignen sich integrierbare

3D-Kameras oder -Module, die auf eine Kombination aus passiver und aktiver Stereo Vision setzen.

Kameramodule und Künstliche Intelligenz

Neuartige 3D-Kameras und Embedded Vision-Module wie beispielsweise die Intel® RealSense™-Reihe verknüpfen aktive und passive Stereo Vision-Verfahren und eignen sich damit für alle Arten von Oberflächen. Der Pattern-Projektor kann bei Bedarf ein- oder ausgeschaltet werden und sorgt auf homogenen Texturen für Referenzpunkte. Unabhängig von aktiver oder passiver Vorgehensweise war die Berechnung der Triangulation und Erstellung der Tiefenkarten bisher sehr rechenaufwändig. Sie wurde zumeist auf separaten Host-PC‘s durchgeführt. Integrierte 3D-Lösungen haben für das Processing einen ASIC-Chip direkt hinter dem Bildsensor installiert, der ausschließlich 3D-Operationen übernimmt und für eine Verarbeitung in Echtzeit sorgt.

Bei der Zuordnung und Korrelation der Bilddaten können intelligente Algorithmen helfen, die Qualität der Tiefenbilder zu erhöhen und die Fehlertoleranz zu minimieren. Das meiste Potenzial erzielt künstliche Intelligenz allerdings, wenn die 3D-Informationen innerhalb einer Anwendung genutzt werden um Prozesse intelligent mit präzisen Bildinformationen in Echtzeit zu automatisieren und zu steuern. Mittels 3D-Technologie und bildbasierter KI können Maschinen Umgebungen und Objekte exakt analysieren und eine neue Wahrnehmungsebene generieren. Intelligente Algorithmen können mit 3D noch präzisere und schnellere Analysen und valide Entscheidungen treffen. An einem Förderband zur Sortierung von Paketen beispielsweise kann ein neuronales Netzwerk alleine lernen, was die Objekte kennzeichnet und sie so zukünftig selbst erkennen und klassifizieren. Machine Learning funktioniert mit 3D deutlich besser, da mehr Informationen vorliegen und keine langwierigen Annahmen und Schätzungen gemacht werden müssen. Innovative Anwendungen in Industrie und Alltagsleben profitieren von der Kombination aus 3D Technologie und Künstlicher Intelligenz und macht Maschinen zu intelligenten Partnern.